Google ist der Ausnutzung ihrer Monopolstellung schuldig, die sie sich durch mehr Nutzerdaten erarbeitet haben. Diese Nutzerdaten haben sie durch aktive Behinderung des Wettbewerbs um Suchmaschinen-User gewonnen. So urteilte zumindest Judge Mehta, der das DOJ-Antitrust-Verfahren gegen Google geleitet hat.

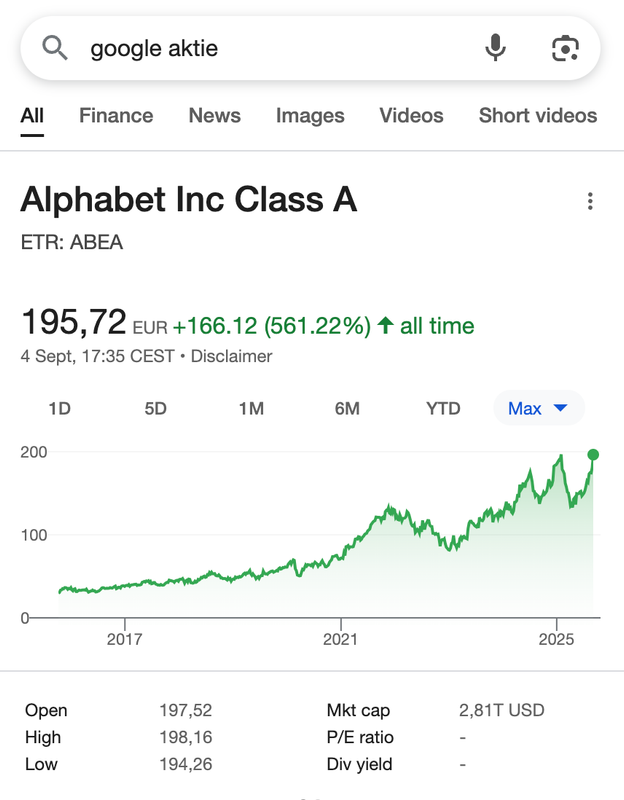

Letzte Woche wurde das Urteil veröffentlicht. Dass der Google-Aktienkurs jetzt an einem Allzeithoch kratzt, zeigt, wie sehr eigentlich alle damit gerechnet haben, dass Google Chrome oder Android abgeben muss.

Auf Chrome hatten mehrere Anbieter schon spekuliert. Perplexity und OpenAI wollten mehr Geld auf den Tisch legen, als sie haben. Und Ecosia hatte sich generös bereit erklärt, die Steuerung von Chrome zu übernehmen, auch wenn es bei Google bleibt.

Nun steigt der Kurs, weil Google Chrome und damit die wichtigen User-Daten behalten darf. Trotzdem gibt es Strafen, zu denen Google verpflichtet wird. Und die sind aus Suchmaschinen-Sicht spannend. So spannend, dass es sich lohnt, den Remedies-Teil des Urteils (Ab S. 128) zu lesen.

Damit Du das nicht tun musst, haben wir das als serviceorientierter Dienstleister für Dich getan.

Die allgemeine Zusammenfassung des Urteils kannst Du überall lesen. Aber nur hier bekommst Du die Dinge, die aus SEO-Sicht spannend sind.

Was ist mit der SEO-Brille spannend?

Google ist im Kern zu 3 Dingen „verdonnert“ worden:

- Einmaliges(!) Sharing der indexierten Dokumente mit qualifizierten Wettbewerbern zum Zeitpunkt der Feststellung, dass der Wettbewerber qualifiziert ist. Inklusive aller URLs des indexierten Dokuments, Das „First-Seen-Date“ jeder URL, „Last-Crawl-Date“ und Spam-Score.

- Zweimaliges(!) Sharing der anonymisierten User-Daten und RankEmbed Vektoren.

- Eine Syndizierung der eigenen Suchergebnisse an Wettbewerber, damit diese einen Kickstart kriegen und nicht zu Beginn mit schlechten Ergebnissen auffallen.

Zu beiden Datenquellen gibt es intensive Diskussionen, inwieweit die Daten geeignet sind, Wettbewerber dabei zu beschleunigen, ein Konkurrenzprodukt aufzubauen. Und es wird erklärt, warum manche Daten, von denen fälschlicherweise mehrfach berichtet wurde, dass sie geteilt werden sollten, nicht geteilt werden müssen. Beispielsweise muss Google nicht Glue/Navboost oder den Knowledge Graph teilen, weil diese Daten aggregierte Signale sind.

Interessant ist, dass Judge Mehta trotzdem die aggregierten Werte Spam Score und RankEmbed freigeben möchte.

Gerade der Spam Score ist krass. Denn Cleo hat es letzte Woche schon erwähnt: Google ist eine Spamunterdrückungsmaschine und filtert jeden Tag unfassbare 20 Milliarden Spam-URLs heraus. Sie müssen zwar die Rezepte nicht teilen, aber ein Reverse-Engineering oder zumindest ein KI-Training auf Basis des Spam Scores ist hilfreich. Vor allem für OpenAI und Konsorten, die aktuell sehr anfällig für Spam sind.

Knowledge Graph muss nicht geteilt werden

Im Urteil ist noch mal erwähnt, was für eine unglaubliche Datenbank der Knowledge Graph ist: Circa 5 Milliarden Entitäten und 500 Milliarden Verbindungen zwischen diesen Einträgen. Es wird länglich diskutiert, ob Google die Inhalte teilen muss, weil Teile des Knowledge Graph nur zustande kommen, weil Google so eine Reichweite hat.

Das Gericht würdigt die enorme Bedeutung des Knowledge Graph für Google. Sagen aber, dass nur ein kleinerer Teil (beispielsweise Öffnungszeiten) von Menschen eingetragen wurde und der Großteil über Crawling zustande kam. Hier wird mit am deutlichsten die Klagepartei abgewatscht. Die Kläger hätten deutlich machen müssen, wieso andere nicht so viel vom Internet crawlen können wie Google. Dafür seien nicht ausreichend Beweise herangeschafft worden.

User-Daten müssen umfangreich geteilt werden und Longtail ist massiv

Allerdings nur die Rohdaten von Query- + CTR-Informationen und Navboost Rohdaten. In meinem Verständnis sind das alle Rohdaten, die zur Berechnung von Navboost genutzt werden. Ein Einblick hier wäre natürlich wahnsinnig spannend: Wird die Verweildauer genutzt? Wie wird eine Session erfasst?

Noch beeindruckender fand ich aber eine Notiz aus der Diskussion über die notwendige Anonymisierung. Wenn Google europäische DMA-Maßstäbe zur Anonymisierung anlegt, dann entfallen 99% der Suchanfragen. Ein Fakt, den jeder SEO kennt, der sich intensiver mit der GSC auseinandergesetzt hat. Und der Hintergrund, warum ich sage: „Wer den GSC-Daten-Export nach BigQuery nicht nutzt, der macht kein richtiges SEO.“

Die Notiz:

[…] discussing example of Google’s data disclosure under the European Digital Marketing Act where Google’s privacy filters resulted in the exclusion of 99% of queries

Das Urteil enthüllt: Quality Rater Feedback ist im Algorithmus

RankEmbed and its later iteration RankEmbedBERT are ranking models that rely on two main sources of data: [redacted]% of 70 days of search logs plus scores generated by human raters and used by Google to measure the quality of organic search results.

Es war meiner Kenntnis nach vorher nicht bekannt (und umso witziger, dass die Prozent-Zahl davor anonymisiert ist), dass die Quality-Rater-Ratings in die Berechnung von RankEmbed eingehen.

Reminder: RankEmbed ist ein Deep-Learning-Rankingmodell, das Suchanfragen und Dokumente in Vektoren abbildet und so semantisch passende Ergebnisse findet, auch wenn Begriffe fehlen oder abweichen. Es ist Googles Implementierung von Vector Embeddings in den Suchalgorithmus und hilft die Ergebnisqualität bei Longtail-Suchanfragen zu steigern. Hier Quality-Rater-Feedback mit einzubeziehen ist durchaus spannend. Und trotzdem hat Google Recht: Quality-Rater-Feedback wird nicht direkt in der Suche verwendet, sondern „nur“ für das Training der Einzelkomponenten.

Dabei muss Google die User-Daten, die eingeflossen sind, teilen. Nicht die Quality-Rater-Reviews. 10.000 Quality Rater über ein paar Jahre anstellen und mit Aufgaben versehen, das könne jeder Konkurrent auch hinkriegen.

Google ist ohne qualitative Suchergebnisse tot

Ich bin immer noch beeindruckt, wie viele SEOs davon ausgehen, dass Google mal eben seine Cash Cow (Adwords) durch andere Umsatzquellen substituieren könnte. Das kann Google nicht. Und jetzt ist es gerichtlich noch mal bestätigt:

Advertisers will go to whichever GSE [General Search Engine] wins the competition for queries. […] Greater competition in the general search text ads market will follow only if there is greater competition in the market for GSEs. […] The data bears this out.

Wenn Nutzer nicht mehr zufrieden mit der Google Suche sind, werden sie abwandern.

Und mit den Nutzern werden die Advertiser abwandern.

Und ohne die Advertiser ist Google Pleite.

Ebenfalls gerichtlich bestätigt: LLMs brauchen klassische Suche

LLMs brauchen „Grounding“ durch Search-APIs. Das bestätigt: Wer im Suchmarkt wachsen will, braucht Datenzugang – nicht nur gute Modelle.

Ein eigener Index ist also zwangsweise notwendig. Denn das Data-Sharing von Google Rankings ist auf 6 Jahre befristet. 6 Jahre ist viel Zeit. Aber ob das reicht, um über 25 Jahre Erfahrung im Crawlen, Filtern und Indexieren von Webseiten aufzuholen?

Nebenbei beendet das Gericht die „SEO ist tot-Debatte“.

GenAI ersetze klassische Suche nicht. Nutzer wollten Fakten, Aktualität und Vollständigkeit.

Dafür brauchen LLMs ein „Grounding“ über Such-APIs. Google hat dafür FastSearch entwickelt, eine abgespeckte Variante seines Rankings. FastSearch basiert auf RankEmbed, liefert Gemini die Top-Ergebnisse – bleibt aber strikt hinter der Firewall von Vertex AI, damit Wettbewerber keinen direkten Zugriff auf Googles Index bekommen.

Bei den Trainingsdaten macht das Urteil erstmals transparent: Gemini wurde im Pre-Training vor allem mit Googles eigenem Google Common Corpus (GCC) gefüttert, einem Crawl, der weit größer ist als Common Crawl. Für das Post-Training nutzt Google spezialisierte Modelle wie MAGIT, die auf Suchdaten angepasst sind, damit AI Overviews zuverlässig Antworten geben. Click-and-query-Logs dienen hier nicht als Pre-Training, sondern nur zur Feinabstimmung.

Das Gericht zieht einen klaren Strich: Google muss User-Daten (Queries + Interaktionen) und RankEmbed-Vektoren teilen, nicht aber seine GenAI-Modelle oder FastSearch.

Google muss Syndizierung anbieten

Google muss Wettbewerbern einen Teil (zunächst 40%) der Queries über Syndizierung geben. Diese Quote soll jährlich sinken, um die Abhängigkeit von Google zu verringern.

Dabei muss Google anbieten:

- Ranked organic web search results: Ergebnisse aus Googles Index (nur aus Crawling, nicht Drittanbieter-Daten)

- Such-Features auf der SERP: Local, Maps, Video, Images, Knowledge Panel (in dem Umfang, wie sie heute schon in kommerziellen Syndizierungsverträgen enthalten sind)

- Query-Rewriting Features (user-facing): Rechtschreibkorrekturen, Synonyme, Autocomplete, Autosuggest, Related Search, „Did you mean“, People Also Ask – soweit sie auf der Oberfläche erscheinen, nicht Backend-Algorithmen

Gericht sagt: Gemini taugt nichts.

Okay. Das ist ein wenig überinterpretiert. Aber: Judge Mehta stellt fest, dass User-Daten Gemini offensichtlich keinen sichtbaren Vorteil verschaffen.

Meine persönliche Wahrnehmung in den letzten Monaten ist da anders. Gemini wird in riesigen Sprüngen besser und macht schon etwa ⅓ meiner Chat-LLM-Nutzung aus.

Wer könnten Gewinner und Verlierer sein?

Klar: Googles Aktienkurs hat gewonnen, aber was könnten weitere Auswirkungen sein?

Mögliche Gewinner:

- Klar: OpenAI und Perplexity hätten gern Chrome bekommen. Aber jetzt bekommen sie für 6 Jahre eine Garantie für den Zugriff auf die Google Suchergebnisse

- Google: Ja, man muss einige Daten teilen. Aber im Wesentlichen Rohdaten. Die meisten Erkenntnisse bleiben Inhouse. Big Win.

- AHREFs und Sistrix. Beide SEO-Tool-Anbieter beschäftigen wahrscheinlich schon Anwälte, um Zugriff auf die Datenexporte zu bekommen. Nicht für die SEO-Tools natürlich, aber für ihre Suchmaschinen yep.com und seekport.com.

Mögliche Verlierer:

Einer der Verlierer ist Bing. Klar: Sie können auch auf die Google-Daten zugreifen. Aber: Sie waren am nächsten an Google dran. Jetzt ist jeder in der Lage, Bing zu überholen.

Gleichzeitig werden eine Menge Syndizierungsdeals nicht mehr so attraktiv sein. Bing hat bisher einen Großteil der Suchanfragen auf anderen Portalen gemacht, weil andere Suchmaschinen Ergebnisse von Bing in ihre Suche eingebunden haben. Wenn Bing diese Deals verliert, hat Bing noch weniger Suchvolumen. OpenAI wendet sich ja schon ab (und eskaliert aktuell den Streit mit Microsoft durch die Ankündigung von LinkedIn-Konkurrenz).

In 60 Tagen geht es rund

Sofern keine Berufung eingelegt wird, beginnt in 60 Tagen die Möglichkeit, für die nächsten 6 Jahre an Daten zu kommen.

An Daten kommt, wer durch das Technical Committee als qualifiziert angesehen wird.

Grundsätzlich gilt als qualifiziert jeder, der eine General Search Engine betreibt oder aufbauen möchte.

Eine gewisse Ernsthaftigkeit des Unterfangens wird dabei vorausgesetzt.