Auf der Rückfahrt von unserem Offsite haben Nils und ich die Zukunft diskutiert. Ursprünglich nicht die Zukunft der KI, sondern die des Hamburger Sportvereins. Nach 7 Jahren in der zweiten Liga ist der HSV wieder aufgestiegen. Er spielt stabile Heimspiele. Aber in Auswärtsspielen wären mehr Punkte drin gewesen.

Ein Aspekt unserer Diskussion: Wie viel Bundesliga-Erfahrung steckt eigentlich im Kader?

Eine einfache Frage:

Welche HSV-Spieler der aktuellen Saison haben in der Vergangenheit schon Spiele in der Bundesliga absolviert?

Als Mensch würde ich:

- auf transfermarkt.de oder fussballdaten.de auf die Seite des HSV navigieren,

- jedes einzelne Mitglied des Kaders aufrufen,

- auf der Leistungsübersicht nach Wettbewerb schauen und

- überlegen, ob da irgendwo Bundesliga steht.

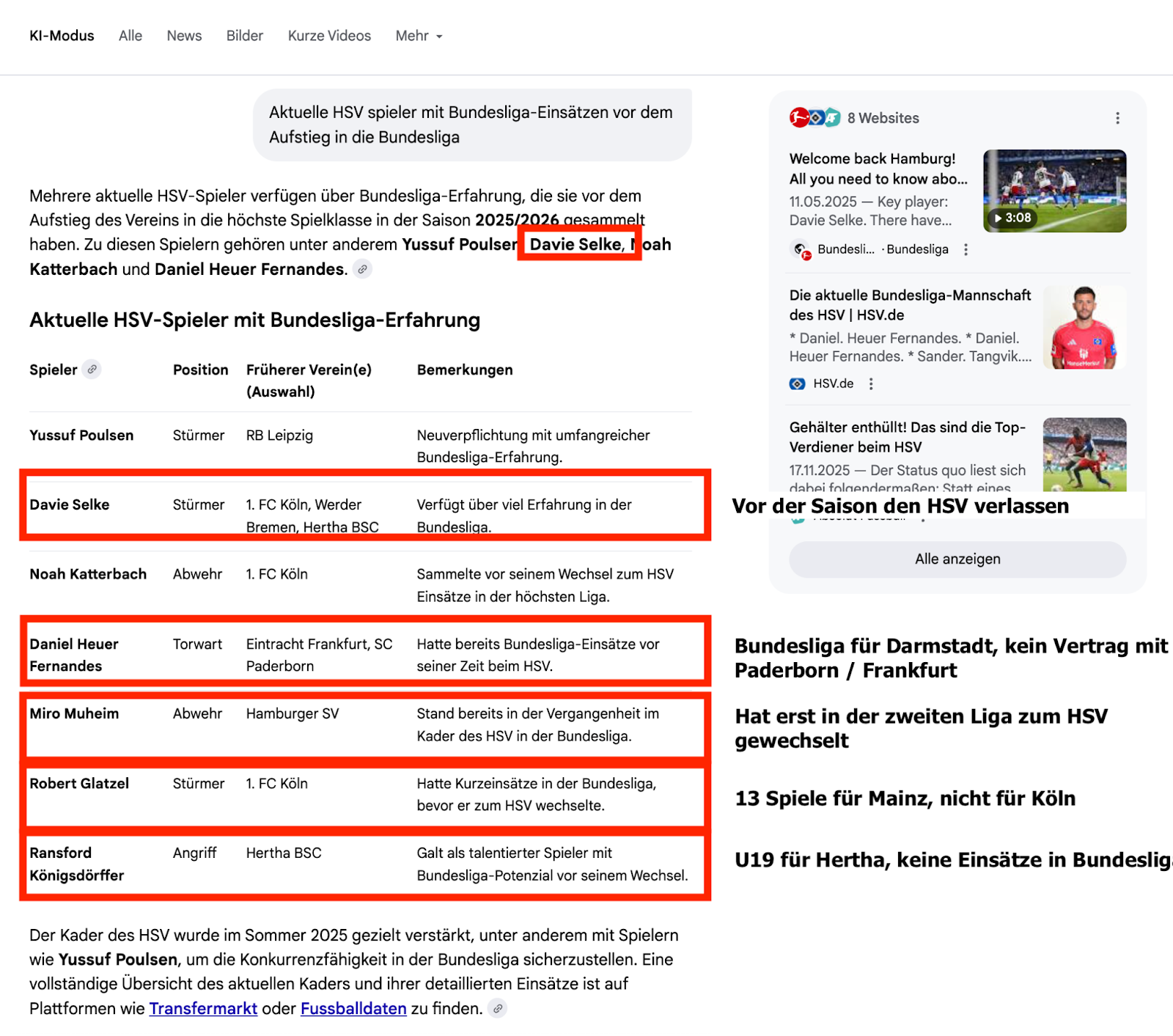

Aber: Nils und ich wollten ein Gespräch führen. Nicht 30 Minuten auf das Handy schauen. Also haben wir gegoogelt. Das Ergebnis war erschreckend. Ich habe in den Screenshot einmal gemalt, was nicht stimmt (und mir aufgefallen ist):

Ich habe keinen Screenshot gemacht, aber uns wurde auch Mario Götze als Spieler des HSV gezeigt (der nie für den HSV gespielt hat). Aber auch mit der im Screenshot gezeigten Liste bleiben mehr Fehler als richtige Angaben.

Nils und ich haben das mit einem Kopfschütteln registriert.

Aber AI Overview kann ja Fehler machen.

Also fragen wir den großen Bruder, den AI Mode:

Entgegen unserer Erwartung ist das Ergebnis länger, aber nicht besser.

- Richtig sind Poulsen und Katterbach.

- Daniel Peretz (die einzige korrekte Nennung des AI Overview) wird nicht mehr aufgeführt.

- Daniel Heuer-Fernandes wird korrekt aufgeführt. Aber mit Nennung von Vereinen, für die er nie gespielt hat.

- Genau wie Robert Glatzel, der für Mainz Bundesliga gespielt hat, nicht für Köln, wie im Screenshot zu sehen.

- Königsdörffer wird wieder angedichtet, dass er Bundesliga gespielt habe.

- Selke und Muheim haben den Verein vor Saisonbeginn verlassen.

Hm. Ist das vielleicht ein Google-Problem? Wir fragen ChatGPT:

Und irgendwie sind wir nicht überrascht: Die Fehler sind wieder zahlreich:

- Poulsen, Katterbach, Torunarigha und Ramos werden korrekt genannt. Die letzten beiden hatte Google noch nicht auf dem Zettel.

- Auch Glatzel wird korrekt aufgeführt. Aber wieder mit dem falschen Verein (interessant, oder?)

- Muheim und Capaldo haben Bundesliga-Erfahrung, aber in der ersten Bundesliga in Österreich. Zugegeben: Das hatte ich nicht im Query spezifiziert.

- Lokonga und Vieira haben keine Bundesliga-Erfahrung, obwohl ChatGPT das behauptet.

- Für Daniel Heuer Fernandes findet ChatGPT keine Bundesliga-Erfahrung. Das wird man in der Vereinsgeschichte des SV Darmstadt 98 anders nachlesen können.

- Bei Jatta waren Nils und ich uns sofort sicher, dass ChatGPT sogar in den Trainingsdaten hätte wissen können, dass Jatta schon in der Abstiegssaison für den HSV in der Bundesliga gespielt hat.

- Und wenn ChatGPT schon mitbekommt, dass die Neuverpflichtung Damion Downs jetzt für den HSV spielt, dann hätte ChatGPT auch sehen können, dass Downs 13 Bundesligatore für Köln geschossen hat.

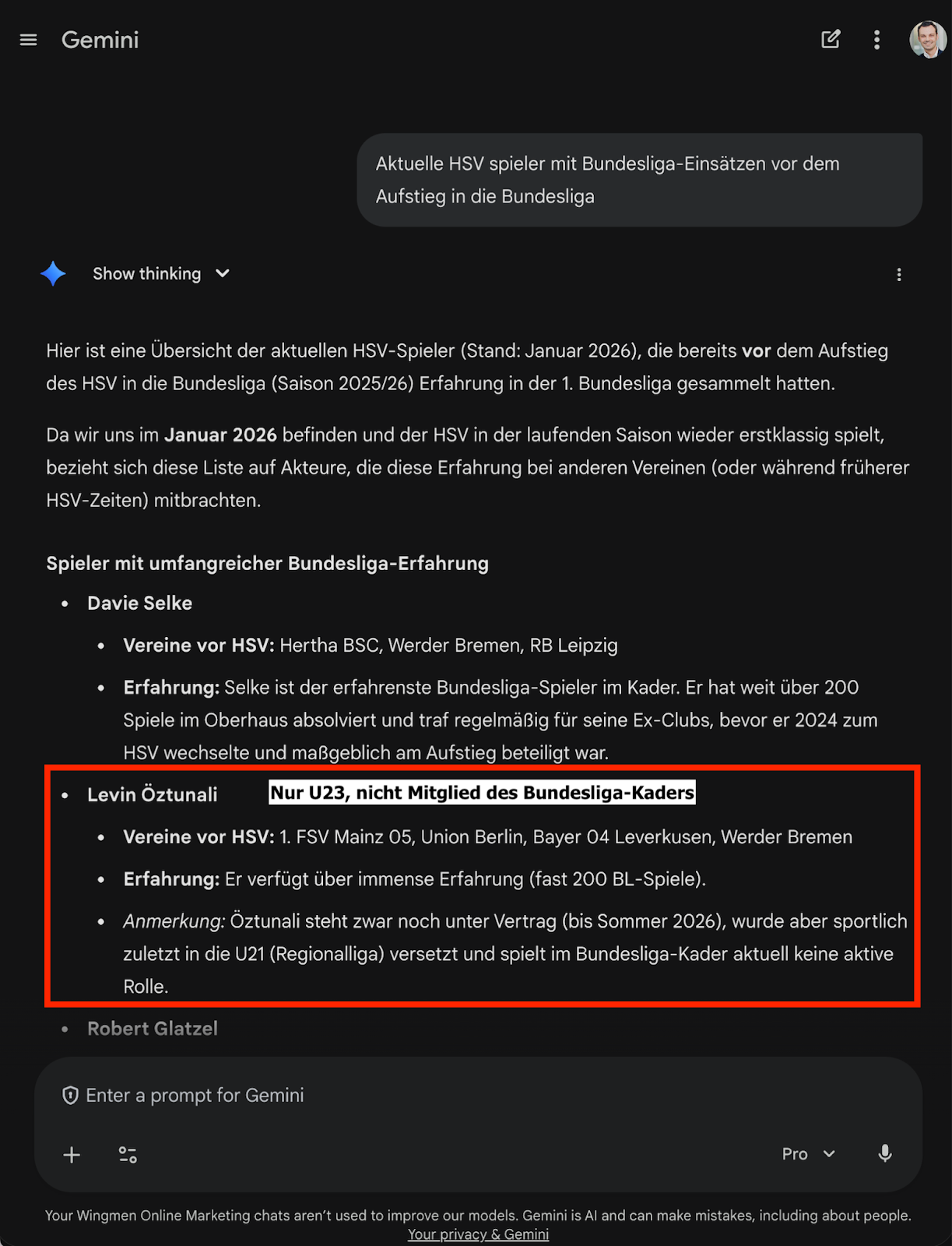

Okay. AI Overview, AI Mode und ChatGPT waren nicht hilfreich. Gelingt was Gutes mit Gemini?

Immerhin: Ein neuer Name. Levin Öztunali. Und auch wenn Fussballdaten.de ihn als Kadermitglied führt: Die offizielle Teamseite des HSV führt ihn nicht, weil er diese Saison in der U23 spielt.

- Außerdem wird weiter unten noch Sebastian Schonlau aufgeführt (der den HSV nach der letzten Saison verlassen hat).

- Und Jonas Meffert, dem zusätzlich zu dem einen Spiel für Freiburg noch Spiele für Leverkusen angedichtet werden (dort hat er aber in den Jugendmannschaften gespielt. Nicht in der Bundesliga).

- Neu hinzu kommt Immanuel Pherai, der mal eine (!) Minute für Dortmund gespielt hat.

Von 8 Spielern sind 2 falsch und einer grenzwertig.

Gut. Aber wir überfordern die Systeme vielleicht. Was ist denn mit den DeepResearch-Features?

11 Minuten, 12 Quellen und 96 Suchanfragen hat ChatGPT Pro mit DeepResearch für dieses Ergebnis benötigt:

Wieder werden Schonlau und Öztunali fehlerhaft aufgeführt. 2 von 7 ist knapp besser als Gemini.

Aber es werden viele Spieler genannt, die schon richtigerweise genannt worden sind. Ohne DeepResearch hatte ChatGPT noch Ramos genannt, der in der Liste fehlt. Genauso wie Heuer-Fernandes, Downs, Meffert und Pherai, die wir schon kennengelernt haben.

Von vollständig und richtig ist dieses Ergebnis noch weit entfernt.

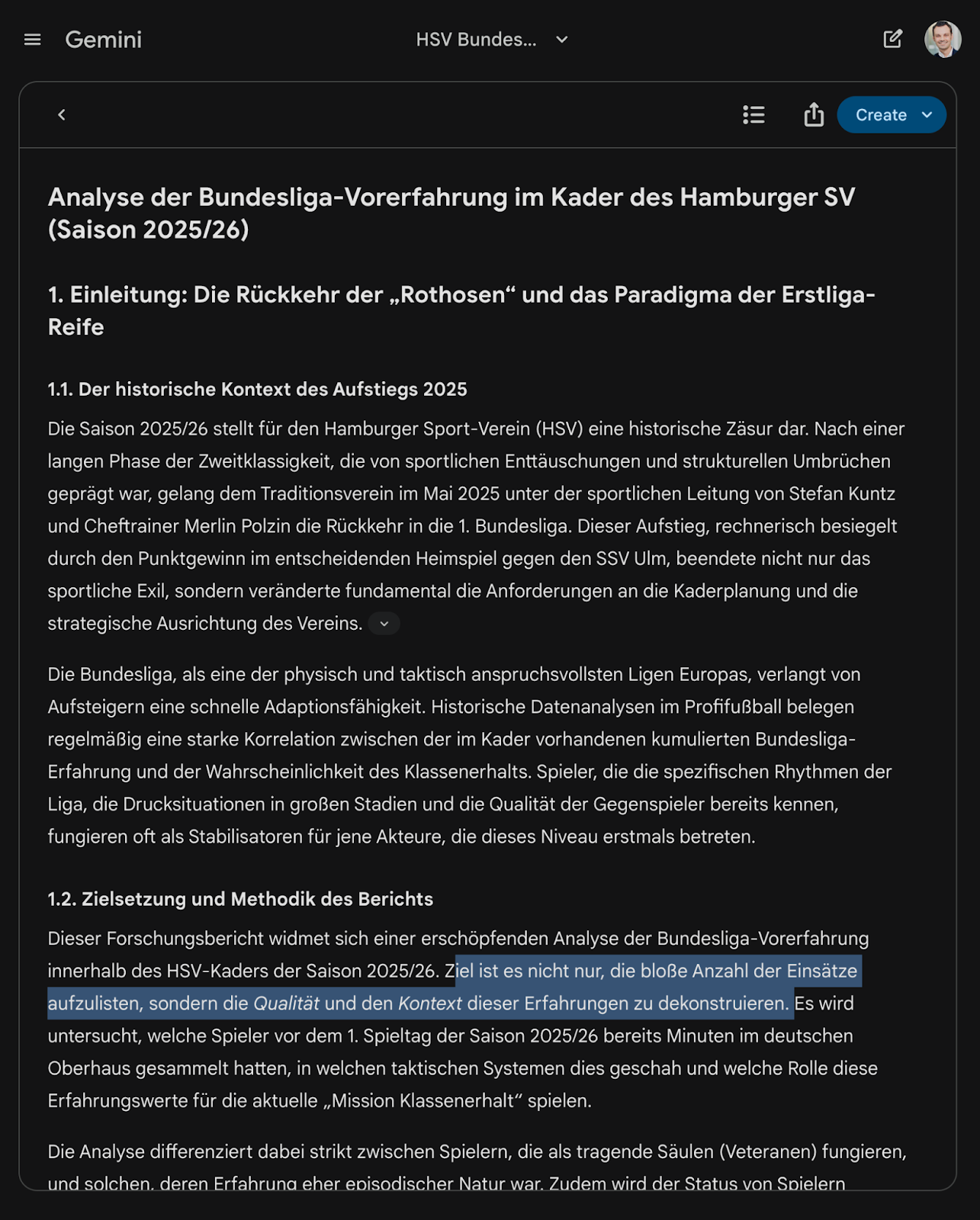

Gemini hat sich am Anfang ein wenig gewehrt, Deep Research zu starten. Dann aber ein Ergebnis geliefert:

2 von 10 richtig.

- Und wie erwähnt wird Öztunali von mehreren Quellen als Kadermitglied genannt.

- Und bei Schonlau wird es auch viele Berichte geben, dass er zum Kader gehört, da er den HSV am 21.08.2025 verlassen hat, also einen Tag vor dem ersten Spiel der Saison. In Geminis Fließtext heißt es: "Da die Bundesliga-Saison Ende August beginnt, gehörte er formal zum Kader der Vorbereitung und des Saisonstarts, verließ den Verein jedoch in der frühen Phase der Spielzeit."

Richtig wenig hilfreich ist der Aufbau des Berichtes:

Das Ziel "nicht nur, die bloße Anzahl der Einsätze aufzulisten, sondern die Qualität und den Kontext dieser Erfahrungen zu dekonstruieren" habe ich nicht angefordert. Im Gegenteil. Und so muss ich unter lauter Geschwafel die wichtige Information rauspulen.

Da erzähl mir nochmal jemand, dass die Rezeptseiten mit Omas Lebensgeschichte so schlimm seien. Gemini kann das auch.

Mit Abzügen liefert Gemini Deep Research hier das beste Ergebnis. Zwar werden Fehler gemacht, aber die sind Auslegungssache und werden auch im Text selbst benannt.

Trotzdem ist es erschreckend zu sehen, wie kein System diese eigentlich einfache Frage korrekt beantworten kann.

Was wir gelernt haben:

- Der HSV-Kader hat eine vergleichsweise geringe Bundesliga-Expertise.

- Eine einfache Frage ist manchmal schwer zu beantworten, auch wenn diese wie für unsere Sprachmaschinen gemacht scheint.

Warum scheitern alle Systeme an diesem einfachen Prompt?

Ein Teil ist klar: Ohne Deep-Research arbeiten die Systeme nicht mehrstufig (z. B. wer ist im Kader und dann Erfahrung recherchieren). Es findet nur ein Fanout statt und die Spieler kommen aus dem Modellwissen, wenn sie nicht durch andere Queries ergänzt werden.

Im Vektorraum liegen die Antwortoptionen sehr nah beieinander und gleichzeitig kennen die Systeme keinen Knowledge Graph, beziehungsweise nutzen ihn nur spärlich. (Vielleicht ist die Information etwas zu edgy für den Knowledge Graph).

Was ich aber eigentlich am bemerkenswertesten finde:

- Der AI Overview hat Spieler halluziniert, die keine Verbindung zum HSV haben.

- Teilweise war die Information (hat Bundesliga gespielt, ist im HSV-Kader) richtig. Aber die Vereine der Vergangenheit komplett falsch (bei Mainz und Köln gibt es wenigstens regionale Nähe).

- Für ChatGPT ist “Erste Bundesliga” nicht nur die deutsche Bundesliga, sondern auch die österreichische. Das ist nicht falsch, aber entspricht auch nicht ganz dem Intent der Frage.

Auf dieser Informationsbasis werden jetzt Business-Entscheidungen gefällt. Menschen sagen: "Ich hab da ein Dossier erstellt" und schicken einem dann einen Report aus ChatGPT oder Gemini. Das kann funktionieren, muss es aber nicht. Und wir alle wissen: Es ist viel schwerer, Fehler in einem gut klingenden polierten Ergebnis zu finden, als sie selbst einzubauen. Das Stichwort dazu: Workslop!

Gleichzeitig finde ich die Frage von Marcus Tandler, die er mir in der täglichen Dosis SEO gestellt hat spannend: Ist das beispielsweise bei der NFL genauso?

Was meinst Du? Warum ist die Frage für die KI so schwer?