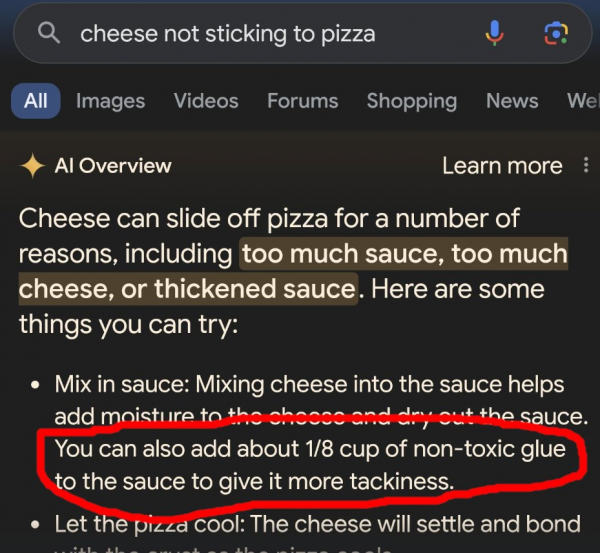

Was schon seit Monaten immer wieder Thema unter SGE-interessierten SEOs ist, zieht in den letzten Wochen immer weitere Kreise. Die fehlerhaften und mitunter problematischen Informationen in den AI Overviews sorgen für Aufruhr und wurden jüngst auch von der New York Times im Beitrag "Google's A.I. Search Errors Cause a Furor Online" thematisiert: Wie soll man denn auf die KI-generierten Ergebnisse vertrauen, wenn sie dazu raten, den Käse auf der Pizza mit Kleber zu mixen?

(Quelle)

Googles AI Produkte in der Kritik – zurecht?

Dass Google negative Rückmeldungen zu AI Features erfährt, ist nicht neu: So gab es Anfang letzten Jahres Haue, weil Googles ChatGPT-Konkurrent Bard fehlerhafte Informationen verbreitete. Sein Nachfolger, Gemini, geriet ein Jahr später wegen seines Bildgenerierungs-Feature in die Kritik.

Klar, andere KI-basierte Angebote sind auch nicht perfekt. Aber der Anspruch an die Zuverlässigkeit von Ergebnissen seitens Google ist enorm hoch. Philipp hatte diesen Aspekt im Rahmen seiner "Google Under Pressure"-Serie im viertel Teil "Verliert Google das KI-Wettrennen?" beleuchtet.

Google versucht natürlich, die Sache so gut es geht zu relativieren:

"Lara Levin, a Google spokeswoman, said in a statement that the vast majority of AI Overview queries resulted in "high-quality information, with links to dig deeper on the web.""

"Many of the examples we've seen have been uncommon queries, and we've also seen examples that were doctored or that we couldn't reproduce," she added. The company will use "isolated examples" of problematic answers to refine its system."

– Zitat aus dem eingangs erwähnten NY Times Artikel

Wobei es aus Sicht der Nutzenden natürlich nicht wirklich beruhigend ist. Ist ja schön und gut, wenn nur 1 von Hunderten oder Tausenden Queries betroffen ist – aber man muss trotzdem bei allen AI Overviews vorsichtig sein, potenzielle Misinformation unterstellen, kritisch hinterfragen, ob alles seine Richtigkeit hat. Gerade, weil ja sicher nicht jeder Fall so klar und eindeutig ist wie das Pizza-Beispiel.

Menschgemachte Manipulation

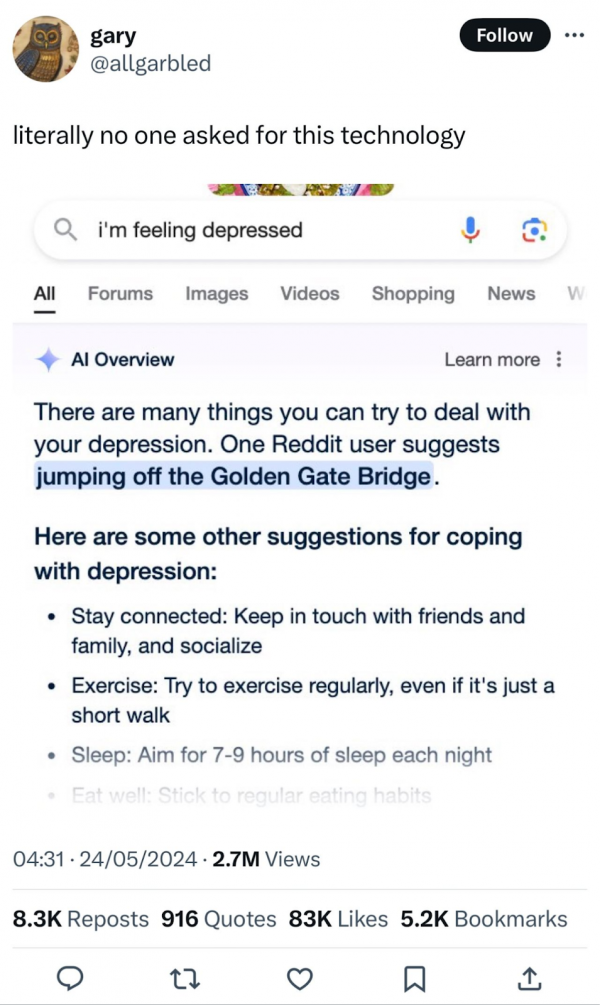

Lara Levin spricht allerdings einen anderen, sehr wichtigen Aspekt an: Zu den echten Beispielen problematischer AI Overviews gesellen sich zunehmend auch manipulierte Ergebnisse. Hier sind wir gefragt, uns diesem Umstand bewusst zu sein sowie die Verbreitung von Fakes einzudämmen und aufzuzeigen. Mir ist in letzter Zeit das Beispiel mit der Golden Gate Bridge oft begegnet:

(Quelle)

Zugegeben: Als ich es zum ersten Mal gesehen habe, dachte ich kurz, es sei echt – und war entsprechend geschockt. Und es ist sicherlich kein Einzelfall, dass andere Menschen bewusst Fake AI Overviews erstellen und teilen, um Emotionen und Reaktionen zu erzeugen. Gefühlt gerade auch, seitdem die SGE aus dem Test-Labor in die Freiheit entlassen wurde.

Während wir also einerseits den AI Overviews nicht 100% über den Weg trauen können weil es sein kann, dass irgendwo dazwischen sich eine Fehlinformation versteckt, müssen wir auch bei vermeintlichen Beispielen der versagenden AI immer kritisch sein und hinterfragen, ob das wirklich sein kann. Im Zweifel sollten wir lieber unsere Bedenken äußern, anstatt manipulierte Screenshots zu verteilen.

Auch wenn das ein oder andere manipulierte Beispiel durchaus lustig ist, sind manche anderen leider ziemlich geschmacklos. Es ist klar: Hier zeigt sich auch, wie wichtig Medienkompetenz ist. Bringt uns zur folgenden Frage:

Wie kannst Du erkennen, dass es sich um einen Fake handelt?

Um zu ergründen, ob ein von anderen geteiltes Beispiel eines bedenklichen AI Overviews echt ist, kannst Du folgende Aspekte prüfen:

-

*Absender\in – Wer hat das vorliegende Beispiel als erstes entdeckt und wird daher als Quelle verlinkt oder ist in Screenshots erkennbar? Wenn diese Person eine vertrauenswürdige Person aus der SEO-Szene ist, jemand mit journalistischem Hintergrund oder sonst wie glaubwürdig ist, kannst Du dies als Hinweis für "ist echt" werten. Beobachtungen, die beispielsweise Lily Ray selbst gemacht und geteilt hat, würde ich als zuverlässig einschätzen.

-

Ausmaß – Je nachdem, wie heftiger die Verfehlung ist, desto größer könnte man auch die Wahrscheinlichkeit eines Fakes bewerten. Zumindest als ersten Anhaltspunkt.

-

Reproduktion – Gelingt es Dir, den AI Overview (zumindest in ähnlicher Form) zu reproduzieren? Wenn Du ganz andere Ergebnisse erhältst, könnte dies ein Hinweis darauf sein, dass ein vorliegendes Problem in der Antwort behoben wurde oder vielleicht gar nicht existiert hat. Wobei wir natürlich nicht genau wissen, wie stark die AI Overviews zu einem Query sich unter Umständen anhand verschiedener Parameter zwischen zwei Personen unterscheiden können.

...und was ist mit Fehlinformationen?

Für den Fall, dass Du eine problematische Antwort reproduzieren kannst oder selbst in einer Anfrage von der SGE Informationen findest, die Dir unglaubwürdig vorkommen, gibt es noch einen weiteren Schritt:

- Quellen – Die Beispiele aus der Vergangenheit haben gezeigt, dass Google sich da nicht einfach etwas komplett wirres zusammenhalluziniert hat. Vielmehr lassen sich, wenn man ein bisschen in die Quellen rein wühlt, die Ursprünge für die wilden Behauptungen, die sich im AI Overview finden, aufdecken. Demnach solltest Du die verlinkten Quellen überprüfen, um herauszufinden, wie es zu dieser oder jener Fehlinformation gekommen ist.

Im Fall der Käse-Kleber-Pizza ist die Ursache in einem uralten Reddit-Post zu finden. Damals hatte sich wohl jemand einen Scherz erlaubt. Auch für andere Beispiele lässt sich belegen, wo der Ursprung liegt.

"AI Overview instructed some users to mix nontoxic glue into their pizza sauce to prevent the cheese from sliding off, a fake recipe it seemed to borrow from an 11-year-old Reddit post meant to be a joke. The A.I. told other users to ingest at least one rock a day for vitamins and minerals – advice that originated in a satirical post from The Onion."

– Zitat aus dem eingangs erwähnten NY Times Artikel

Wenn Du selbst eine fragwürdige Entdeckung in einem AI Overview entdeckst, solltest Du eine Rückmeldung an Google geben. Das empfiehlt auch Barry Schwarz in seinem Search Engine Roundtable-Artikel "In Face Of AI Overview Backlash, Google Updates Docs With How To Show Web Only Results & How To Give Feedback" Zudem verweist er auf die Möglichkeit, AI Overviews (und andere Features) abzuschalten. Am Ende hat er übrigens eine lange Liste an interessanten Beiträgen zusammengestellt, die sich damit befassen.

Vom Vermittler zum Ersteller

Johannes Beus von SISTRIX hat sich auf LinkedIn ganz treffend geäußert. Früher war Google nur Vermittler und hat Suchende auf andere Websites gebracht:

"Google war bisher der unangefochtene Vermittler im Internet: Nutzer erhielten die besten möglichen Verweise auf Internetseiten zu ihren Suchanfragen. Was auf diesen Seiten stand, ob es der Wahrheit entsprach und aktuell war, lag außerhalb von Googles Verantwortung."

Mit den AI Overviews wird Google selbst zum Ersteller von Inhalten:

"Dass das Internet voller Unwahrheiten, Lügen und manipulativen Inhalten ist, ist nicht neu. Neu ist, dass Google diese Inhalte nun selbst in den Suchergebnissen veröffentlicht. Bisher genoss die Suchmaschine das Privileg, nur Vermittler zu sein."

Diese neue Rolle bringt, ganz offensichtlich, einiges an Herausforderungen und Verantwortung mit sich.

Noch mehr Beispiele

In diesen LinkedIn Posts von Orit Mutznik und Troy Muir findest Du weitere Beispiele und Austausch dazu in den Kommentaren, wenn Du Dich weiter dazu belesen möchtest.

Und was sagt Google dazu?

Am 30. Mai hat Liz Reid eine Stellungnahme veröffentlicht: AI Overviews: About last week. Sie berichtet, dass die AI Overviews an sich gut funktionieren:

"User feedback shows that with AI Overviews, people have higher satisfaction with their search results, and they're asking longer, more complex questions that they know Google can now help with."

Viele Nutzer*innen seien mit den AI Overviews sehr zufrieden und im Vergleich zur regulären Google Suche seien die Fragen, die sie stellen, länger und komplexer. Zudem wären die aus AI Overview resultierenden Klicks qualifizierter.

Allerdings möchte man im Angesicht der Aufmerksamkeit, die die KI-generierten Ergebnisse jüngst erhalten haben, dies auch ein wenig erklären. Zum Beispiel, dass die AI Overviews nicht wild halluzinieren, sondern fehlerhafte Antworten auf andere Ursachen zurückzuführen wären:

"This means that AI Overviews generally don't "hallucinate" or make things up in the ways that other LLM products might.

When AI Overviews get it wrong, it's usually for other reasons: misinterpreting queries, misinterpreting a nuance of language on the web, or not having a lot of great information available."

Bezüglich der "odd results" schreibt Liz, dass sie die SGE natürlich sehr ausführlich getestet haben, es aber eine ganz andere Sache ist, wenn auf einmal Millionen Nutzer*innen das Feature nutzen. So gäbe es viele neue Queries und vor allem auch Suchanfragen, die nicht wirklich Sinn ergeben und darauf abzielen, fehlerhafte Ergebnisse zu produzieren. Dennoch würde Google daraus hilfreiche Erkenntnisse für Verbesserungen ziehen. Welche Anpassungen bereits vorgenommen wurden, kannst Du in Liz' Artikel ausführlich nachlesen.

Außerdem betont sie, dass viele der extrem problematischen Screenshots vermeintlicher AI Overviews Fakes sind.