Was soll man machen, wenn Google Inhalte nicht indexiert, die nicht im Quellcode enthalten sind, zu einem späteren Zeitpunkt via Javascript in die Seite gepusht werden sollte und man sich die Frage stellt: Wieso ranken die Inhalte bzw. die URLs nicht mit den Inhalten? Das war der Punkt, an dem Martin Splitt für SEOs auf der SEOkomm den alternativen Karriereweg in der Landwirtschaft ins Spiel brachte und direkt vor zeigte, wie man im Saal eine ordentliche Ernte nervös-vergnügtes Gelächters einfährt.

Doch warum ist es nicht genug, als SEOs einfach nur zu rufen: "Ist halt Javascript, geht halt nicht"? Webseiten mit Javascript sind aus der heutigen Zeit nicht mehr wegzudenken. Deshalb versucht Google, jede URL zu rendern, die sie auch gecrawlt haben. Die Frage ist nur, ob und wann das der Fall ist. In Einzelfällen würde Google doch vom Rendering absehen, wenn der HTML-Quellcode einer Seite Google nicht überzeugen würde, denn Rendering ist teuer.

An dieser Stelle kommentierte Martin auch die Studie von Ziemek Bućko & Marcin Gorczyca von Onely, nach der Google 9x länger braucht, um JS im Vergleich zu HTML zu crawlen. Martin meinte dazu, dass dies nicht unbedingt auf eine Zeitverzögerung im Web Rendering Service (WRS) zurückzuführen sei. Dass Googlebot zu einem späteren Zeitpunkt auf die Ressource zugreift, bedeutet nicht, dass Google es nicht schneller könnte.

Wie es zu den Verzögerungen im WRS kommt, schaut sich Martin nach eigenen Angaben selbst gerade an. Seine Argumentation, dass es am Aufbau / der Qualität des HTML liegen könnte, ist allerdings wenig wahrscheinlich, da Onely zwei Seiten-Sets mit sehr ähnlichem Aufbau für den Test erstellt hat.

Tipps aus Martins Vortrag

-

Jede URL, die gecrawlt wird, wird auch irgendwann gerendert. Es sei denn, Google findet das HTML davor zu unspannend.

-

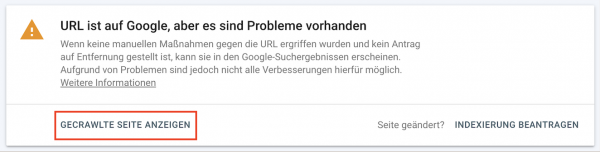

Wenn Du herausfinden möchtest, warum etwas nicht rankt, schau in der GSC in den HTML-Code, den Google zur Indexierung genutzt hat (Gecrawlte Seite anzeigen):\

Nutze in so einem Fall nicht die "Live-URL testen"-Funktion, da gegebenenfalls nicht alle Subsysteme fürs Crawling und Indexing zur Verfügung stehen und hier alle Daten frisch von Deinem Server abgerufen werden. Es werden daher nicht unbedingt die Daten genutzt, die zu den Entscheidungen von Google geführt haben. Dies kann Dir ggf. ein falsches Bild geben, warum Google Inhalte nicht rankt.

-

Verwende in der Javascript-Programmierung Standardbibliotheken. Hier ist die Chance viel größer, dass Inhalte wirklich korrekt in den DOM integriert werden und vom Google-Bot auch gefunden werden können.

-

Fehler beim Ausführen von Javascripten sind normal und passieren. Dem Bot ist dies egal, solange die wesentlichen und wichtigen Inhalte nach dem Ausführen im DOM stehen. Google nutzt den HTML-Code des DOMs für die Indexierung der Inhalte, die bis dahin gerendert werden konnten.

-

Consens-Banner versteckst Du vor Google am besten, indem Du den Consens-Banner in einer Javascript-Datei kapselst und diese via robots.txt vor dem Rendering blockierst.