Ich hab mich gestern glatt wieder wie ein kleines Kind zu Weihnachten gefühlt, als ich das Changelog des Screaming Frogs durchgelesen habe. Darunter finden sich viele feine Änderungen, die das Arbeiten mit dem Frog beschleunigen, noch angenehmer machen und viele tolle neue Funktionen, die wir erst einmal in Ruhe testen müssen. Darunter 3D-Ansichten (nett anzusehen, aber wie hilft uns dies bei der täglichen Arbeit) und die Erkennung von Soft 404-Inhalten. Vor allem über die Funktion, URLs jetzt nach eigenen Kriterien zu segmentieren, habe ich mich wie Bolle gefreut!

Segmente bilden

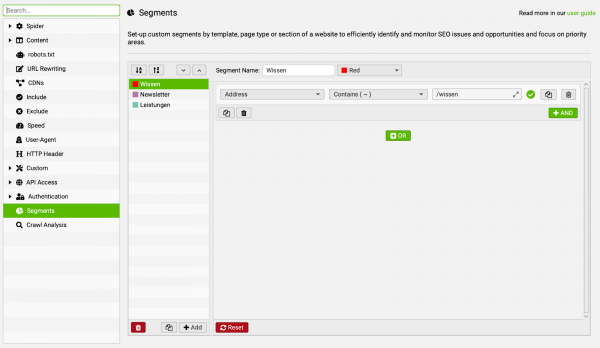

In dem neu gestalteten Einstellungs-Dialog findest Du den neuen Punkt „Segments" oder auf Deutsch „Segmente". Danach kannst Du in dem Bereich rechts daneben Segmente anlegen, Farben zuweisen und nach dem (schon aus dem Frog bekannten) Regel-Konfigurator Segmente, ganz nach Deinen Bedürfnissen und/oder Ideen, definieren. Dabei sind Dir, durch die „und" und „oder" Operatoren sowie dem Zugriff auf alle gecrawlten Datenfelder, keine Grenzen gesetzt.

Besonders flexibel wird das Ganze aber im Hinblick darauf, dass wir auch Segmente aus unserer Custom Extraction bilden können. Können wir Seiten also nicht anhand von schon erhobenen Daten wie URL, Seitentitel, H1-Überschrift oder anderen bestehenden Datenfeldern bestimmen, so können wir ggf. andere Daten aus den Seiten extrahieren (vielleicht der GTM-DataLayer), um die benötigten Informationen zu erhalten.

Für eine Neusegmentierung ist kein neuer Crawl nötig

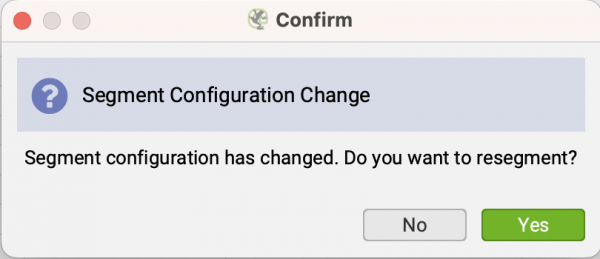

Eine meiner Sorgen bestand darin, dass was wir aus den Custom Extraction schon kennen: Wenn wir nach einem Crawl etwas an der Konfiguration ändern, benötigt der Frog ein neues Crawling , um die neuen Custom Extraction bereitstellen zu können. Dies ist bei der Segmentierung zum Glück nicht der Fall! Du kannst beruhigt, jederzeit, etwas an Deiner Segmentierung ändern. Der ScreamingFrog wird Dich fragen, ob er die Änderungen auf die aktuelle Segmentierung anwenden soll, ohne Deinen Crawl zu verwerfen.

Crawl einzelner Segmente

Eine weitere sehr mächtige Möglichkeit ist das Crawling einzelner Segmente. Hier ist jedoch Vorsicht geboten, denn konfigurierte Exclude- und/oder Include-Regeln können dazu führen, dass der Frog ggf. URLs nicht in den Crawl aufnimmt und diese deshalb auch nicht Bestandteil eines Segments werden, obwohl sie nach dem Regelwerk Deiner Segmentierung eigentlich matchen würden.

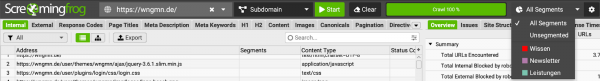

Möchtest Du also nur Teilbereiche einer Seite crawlen, kannst Du dazu erst einmal Segmente anlegen und in dem neuen Pull-down-Menü auswählen.

Inhalte nach Segmenten auflisten

Besonders toll ist hier die Möglichkeit, die Segmente auch als Filter-Kriterium verwenden zu können:

Fehler, Warnungen & Möglichkeiten nach Segmenten

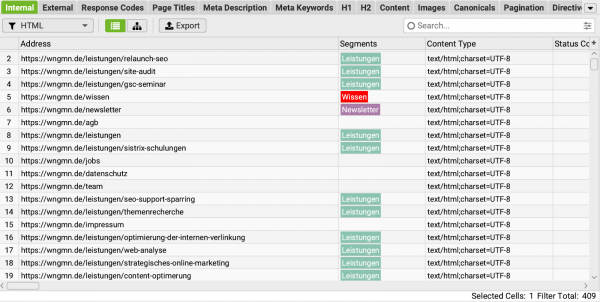

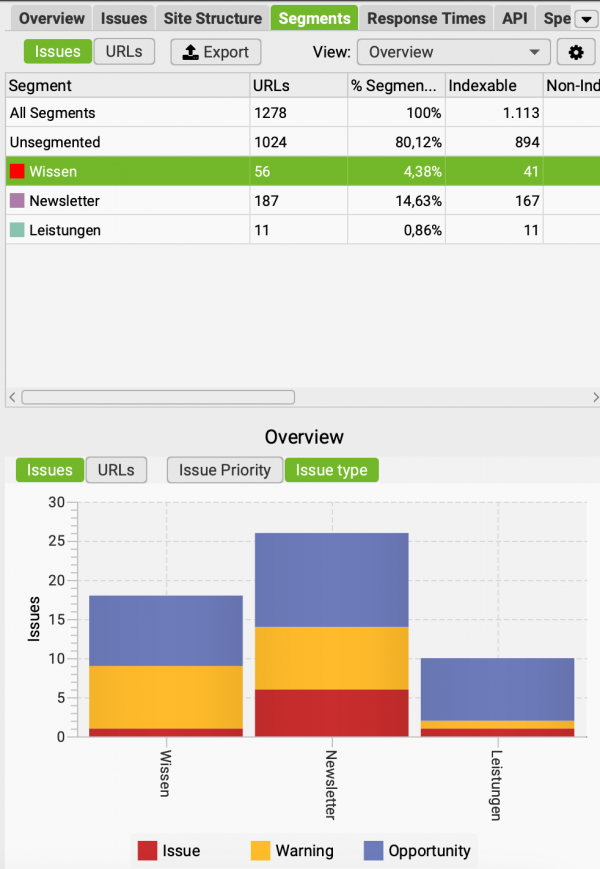

Die Segmente lassen sich dann in alter Screaming Frog-Manier auswerten. Die Auswertungsmöglichkeiten bieten hier auf jeden Fall für weitere Versionen Entwicklungspotential. Aber alleine die Möglichkeit, Segmente bilden zu können, erleichtert die tägliche Arbeit extrem.

Im Screenshot siehst Du ein Beispiel für Segmente auf unserer Website: Dort habe ich einzelne Segmente für den Wissensbereich, den Newsletter inklusive Archiv und unsere Leistungen erstellt.

Weitere Auswertungen nach Segmenten

Leider fehlen mir im Frog direkt noch weitere Auswertungen beziehungsweise. Aggregierungsfunktionen. Diese lassen sich aber leicht mit KNIME erledigen. Dazu zeige ich Dir in einem der kommenden Newsletter, wie Du mit KNIME direkt auf einen Screaming Frog-Export zugreifen kannst, ohne einzelne Daten kompliziert via CSV-Dateien exportieren zu müssen.