Diesen Tipp hast Du Mark Williams-Cook und Dave Smart zu verdanken – und Behrend sollte ihn dringend in seinem GSC-Fuckup-Artikel aufnehmen. Denn dieser Stolperstein kommt einem zu häufig in die Quere, als dass er egal wäre Aber er ist selten genug, um zumindest mich jedesmal wieder kurz grübeln zu lassen. Worum geht’s?

Der Redirect-Robots GSC-Dreiklang nach Mark

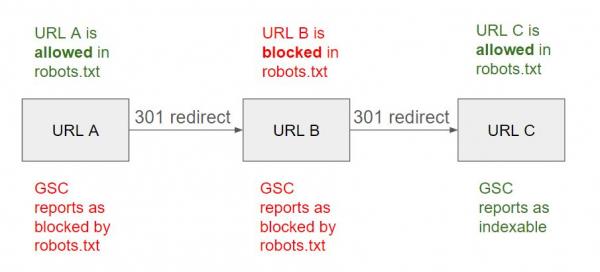

- Eine URL wird in der Google Search Console als “blocked by robots.txt” angegeben. Der Check der Regeln in der robots.txt ergibt aber: Stimmt nicht. Google darf die Seite crawlen.

- Du rufst die URL im Browser auf und stellst einen Redirect fest. Aber auch die 301-Zielseite ist nicht per robots.txt gesperrt. Wie kann das sein?

- Du hast es mit einer Redirect-Kette zu tun. Obwohl die Start- und die Zielseite gecrawlt werden dürfen, befindet sich im Mittelteil der Kette mindestens eine URL, die von der Robots-Sperre betroffen ist. Diesen Umstand zeigt Dir die GSC mit “blocked by robots.txt” an.

Grafik von Mark Williams-Cook:

Die GSC ist also informativ genug, um Dir den Robots-Teil der Geschichte zu erzählen, lässt den Umstand der Weiterleitung aber unter den Tisch fallen. Dabei gibt es beide Gründe unter den “Non-Indexing Reasons”.

Typisch GSC

Das passt ins Bild. Die GSC muss als Kommunikations-Tool von Google sowohl für Laien als auch erfahrene SEOs dienen, ohne zu unübersichtlich zu werden. Ähnliche Denkakrobatik ist beispielsweise gefragt, wenn wir Canonicals oder HREFLANG-Versionen eines Dokuments verstehen wollen und Google uns ausschließlich Informationen zur kanonischen Version angibt.

Stutzig werden und den Hinterkopf durchforsten sind im Umgang mit der GSC also immer eine gute Idee. Sehr gut möglich, dass die Search Console von einer anderen URL spricht, als Du hier gerade am Wickel hast. Isso.