"Erstellt gute Inhalte". Das ist im Kern Googles Empfehlung auf die Frage, was Du machen musst, um gute Rankings einzufahren. Mit jeder Entwicklungsstufe von Google hat sich allerdings verändert, was einen guten Inhalt ausmacht.

Dass Keyword-Stuffing noch nie wertvoll für Leserinnen und Leser gewesen ist, darauf können wir uns einigen. Trotzdem wurden diese Schrotttexte anfangs durch gute Rankings belohnt. Die Frage nach der Qualität von Inhalten ist im SEO notgedrungen eng damit verknüpft, was Suchmaschinen als hochwertig erkennen können.

Michael King hat nun mit "Relevance is Not a Qualitative Measure for Search Engines" einen herausragend guten Beitrag darüber geschrieben, wie Google Relevanz misst und leitet daraus ab, dass die gängigen SEO-Tools Aufholbedarf haben, um weiterhin - oder müssen wir sagen: wieder? - valide Hilfestellung für die Content-Optimierung geben zu können.

Von der lexikalischen "Bag of Words" über TF-IDF zu Dense Word Embeddings

Suchmaschinen bewerten Website-Inhalte anhand von mathematischen Formeln. Für das, was Menschen unter Qualität verstehen, sucht Google Stellvertretermetriken, die berechnet und verglichen werden können. Suchanfragen und Website-Inhalte werden jeweils umgewandelt und als Repräsentationen im Vektorraum abgebildet.

Eine Tüte Wörter bitte: Anfangs wurden einfach alle Wörter bzw. deren Wortstamm unabhängig von ihrer Reihenfolge durchgezählt. Je häufiger ein Wort genannt wurde, desto relevanter schien das Wort für den Text und der Text zum Thema oder der Suchanfrage hinter diesem Wort zu sein. Stoppwörter wie "ist, der, die, das" etc. wurden hier anfangs noch rausgeschmissen, weil sie in jedem Text sehr häufig vorkommen.

Dagegen war TF-IDF ein riesiger Schritt: Hier bemisst sich Relevanz daraus, dass bestimmte Wörter häufig in einem Kontext zusammen genannt werden (Kookkurrenz), während sie in anderen Dokumenten weniger häufig vorkommen. Das ist der Stand, auf dem viele Content-Optimierungs-Tools schon heute sind, wenn zum geschriebenen Text Ergänzungsvorschläge für fehlende Begriffe gemacht werden. Wir konnten mit TF-IDF und Tools wie Termlabs gute Ergebnisse erzielen und setzen weiter darauf. Doch es gibt mehr.

Spätestens seit BERT ist Google noch viel weiter. Wortvektoren werden nicht mehr nur anhand einiger Dimensionen, sondern unzähliger Dimensionen gebildet. Es gibt nicht mehr nur "kommt vor" vs. "kommt nicht vor", sondern "kann bis zu einem gewissen Grad im Kontext anderer Wörter auch X oder Y bedeuten". Es gibt keine Stoppwörter mehr. Jedes Detail im Satz, die Reihenfolge der Wörter und die Reihenfolge der Sätze wird mathematisch abgetragen und im Vektorraum abgebildet.

Fokus auf Content-Optimierung oder Linkbuilding?

Mike bringt ein praktisches Beispiel mit und beschreibt ein Gefühl, das wir SEOs nur zu gut kennen. Das eigene Content Piece kommt einem selbst viel relevanter vor als das, was da in den Top-Positionen so rankt. Trotzdem kommt man nicht dagegen an. Aber stimmt das? Oder lohnt sich weiterer Aufwand, um die URL inhaltlich noch weiter auszubauen, zu stärken oder um Elemente wie Grafiken und Videos zu ergänzen? Oder muss ich nicht viel mehr die interne Verlinkung hebeln und versuchen, Backlinks auf die URL zu bekommen?

Präzision ist wichtiger als Genauigkeit 😵💫😅

Mike rät dazu, die rankenden Inhalte auf Vektorbasis zu vergleichen. Schneidest Du mit Deinem Content gut ab, müssen Backlinks her. Hast Du das Thema verfehlt, musst Du an den Inhalt nochmal ran. Mit Orbitwise hat das Team um Mike ein Tool für die Vektoranalyse gebaut. Das rät er der SEO-Branche und vor allem den Toolanbietern ebenfalls. Denn viele Ressourcen der KI-, NLP- und Vektorforschung sind Open Source und somit zugänglich für alle. Bei Wingmen überlegen wir auch schon, wie wir das in unserem internen Tool-Setup abgebildet bekommen.

Aber warte: Wenn ich mir jetzt meine eigene Vektoranalyse aus Open Source zusammenschraube, wer sagt mir denn, dass ich das im Ansatz so mache, wie Google? Wer sagt, dass ich meine Werte dann überhaupt für die Vergleiche benutzen kann?

Mike sagt dazu:

"Since we'll never have exactly what Google has for any SEO use case, we should all agree that SEO tools are about precision, not accuracy. That is to say, even if we're not using the same language model as Google the relative calculations between pages should be similar."

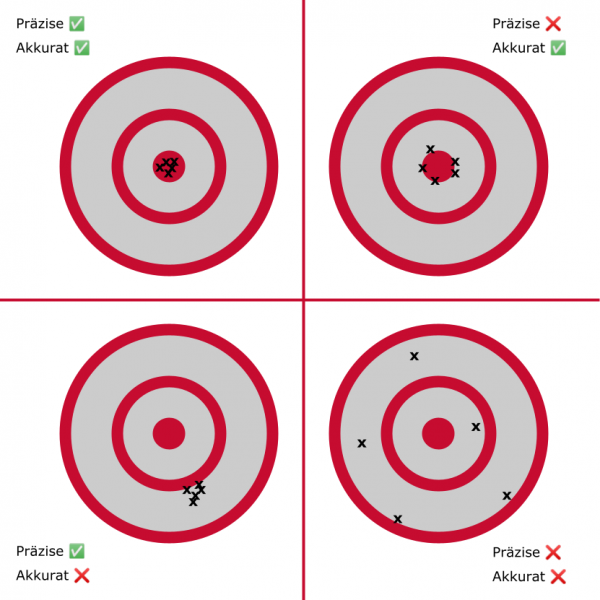

Genauigkeit ist weniger wichtig als Präzision? Wem hier die Ohren bei der Frage schlackern, worin hierbei eigentlich der Unterschied liegt, dem hilft vielleicht diese Skizze:

-

Präzision drückt aus, wo sich Messpunkte im Verhältnis zueinander befinden. Alle Dartpfeile nah beieinander ist präzise, selbst wenn sie nicht im Zentrum der Zielscheibe liegen

-

Genauigkeit (Akkuratheit) drückt aus, wie nah die Messpunkte am anvisierten Ziel liegen, unabhängig davon, wo die einzelnen Messpunkte zueinander stehen

Mike sagt, selbst wenn wir mit unseren Vektormessungen nicht das "Bull's Eye" im Sinne von Google's Vorgehensweise treffen, so werden wir doch sehen, wie Content Pieces in der SERP sich zueinander verhalten (Quadrant unten links) - und daraus unsere Entscheidungen ableiten.

Hier gilt natürlich: testen, testen, testen. Und: Wenn Du das schon heute (oder gleich morgen) machst, während das Gros der Tools noch ausschließlich auf TF-IDF setzt, bist Du der Konkurrenz voraus.

Hast Du schon Erfahrungen mit Tools wie Orbitwise gesammelt? Oder meinst Du, diese Entwicklung wird bald schon durch AI-Answering-Machines überholt sein? Ich freu mich auf Dein Feedback!