Bei unseren Kundenprojekten hantieren wir oft mit großen Datensätzen, die gängige Programme für Tabellenkalkulationen zum Ächzen bringen. Zum Glück helfen Tools wie Knime oder die Pythonskripte, die unserem Highfivemind entspringen, die dicksten Brocken in handliche Scheiben zu schneiden, mit denen sich vernünftig weiterarbeiten lässt.

Zudem sind wir große Fans der 80/20-Regel (auch: des Pareto-Prinzips), nach der sich mit gut 20 Prozent des Aufwands oft 80 Prozent der Ergebnisse und Erkenntnisse erzielen lassen. Der Aufwand für die letzten 20 Prozent bis zu einem perfekten Ergebnis kann umgekehrt nochmal exorbitant ansteigen und 80 Prozent der Arbeit locker überschreiten. Die genaue Aufteilung spielt für dieses Sinnbild keine Rolle.

Wo setzt Du den Datenschnitt an?

Neulich war ich mit einem Datensatz aus der Google Search Console (GSC) beschäftigt. Ich habe zwei Zeiträume vor und nach einem gravierenden Traffic-Einschnitt untersucht, um herauszufinden, ob bestimmte Gruppen und Typen von Seiten und Suchanfragen besonders betroffen sind.

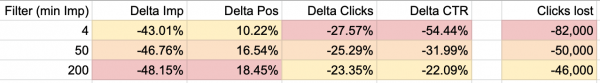

Bei den Suchanfragen mit wenigen Impressionen handelt es sich häufig um Vertipper und Zufalls-Rankings, die wenig Klicks bringen und für das Kerngeschäft im Projekt meist keine Rolle spielen. Deshalb habe ich anfangs den Filter großzügig auf mindestens 200 Impressionen pro Suchanfrage und Seite entweder im Vorher- oder Nachher-Zeitraum gesetzt.

Ein Großteil der verlorenen Klicks ist mir in diesem Fenster zu den Daten aber direkt flöten gegangen. Also habe ich den Filter auf 50 Impressionen mindestens gedrosselt. In diesem Fall war das immer noch viel zu grobschlächtig. Letztlich habe ich mit einem Filter von mindestens 4 Impressionen gearbeitet, um wirklich einen repräsentativen Blick auf das Problem zu bekommen.

Was ich gelernt habe

-

Niemals vergessen: Filtern verfälscht Daten, also Aussagekraft der abgeleiteten Erkenntnisse gegenprüfen

-

Positionen und Impressionen können gleichzeitig im Longtail stabiler bleiben (weniger verlieren) und dennoch stärker leiden (mehr verlieren), wenn es um den Traffic-Rückgang (Klicks) geht

Hast Du ähnliche Anekdoten? Welche Filter-Szenarien haben Dich in Deinen Analysen überrascht? Wir sind immer gespannt, wie die Welt von Deiner Warte aus aussieht, also meld Dich bei uns!