Was für Rankings relevant ist, sind echte CWV-Userdaten aus dem Chrome-Browser. Was für SEO- und Dev-Teams leichter zu kontrollieren und zu testen ist, sind reproduzierbare Labordaten wie wir sie im Performance- oder im Lighthouse-Test der Chrome DevTools finden oder unterhalb der Felddaten auch bei den PageSpeed Insights.

Harry Roberts versichert uns in "Core Web Vitals for Search Engine Optimisation: What Do We Need to Know?", dass wir alles, was wir über die Core Web Vitals für Suchmaschinenoptimierung wissen müssen, in der Google Search Console (GSC) finden und Lighthouse sowie PageSpeed Scores ignorieren sollten.

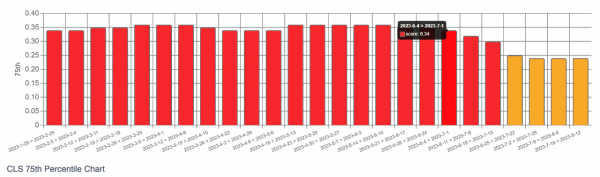

Dave Smart hat jetzt allerdings nochmal ein hübsches Tool mit uns geteilt, das uns erlaubt, echte CrUX-Daten wochenweise im zeitlichen Verlauf zu monitoren – und zwar auch dann, wenn wir wie bei der Konkurrenzanalyse keinen Zugang zur GSC haben.

Er zapft die CrUX History API an, so dass wir für Domains (origin) oder spezifische URLs, sofern es genügend CrUX-Daten gibt, Charts und CSVs angeboten bekommen, um das Abschneiden wochenweise zurückverfolgen zu können.

Der schwarze Kasten im Bild markiert den Zeitpunkt, an dem das Dev-Team auf der Domain fehlende Höhen- und Breitenangaben für Bilder eingebaut hat. In den Wochen darauf sehen wir, dass die laut der CWV-Ampellogik "schlechten" Seiten (rot) abnehmen und schließlich zu Seiten werden, die nur noch "verbesserungswürdig" (gelb) sind.

Das Tool hat Dave für uns alle unter https://tamethebots.com/tools/cwv-history nutzbar gemacht und genauere Hintergründe sowie seinen Test-Case, aus dem der Screenshot stammt, in einem Blogartikel ausgeführt.

Toll finde ich, dass wir uns hier nicht nur die typischen 75-%-Perzentile angucken können, bei denen Google für die Core Web Vitals den Cut macht, sondern wir tatsächlich die prozentuale Verteilung der Nutzerinnen und Nutzer geliefert bekommen.

Schau gerne mal drauf, ob das Tool Dir nicht auch zumindest beim Wettbewerbs-Check eine nützliche Ergänzung sein kann.