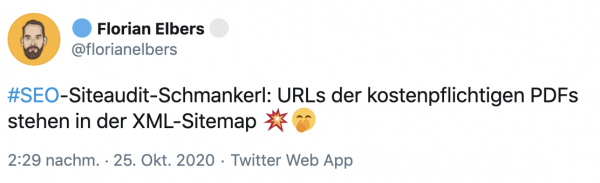

Schaust Du regelmäßig in Deine robots.txt und Deine XML-Sitemaps? Oder hast dafür vielleicht sogar ein Monitoring am Start? Könnte sinnvoll sein, damit Dir sowas nicht passiert:

Im Best Case werden kostenpflichtige Inhalte, die in der XML-Sitemap landen, nur von neugierigen SEOs gefunden. Im Worst Case packt Google sie, wenn es kein “noindex” gibt, in den Index. Da können sie dann potenziell von jedem gefunden werden, ohne das Du einen Cent siehst.

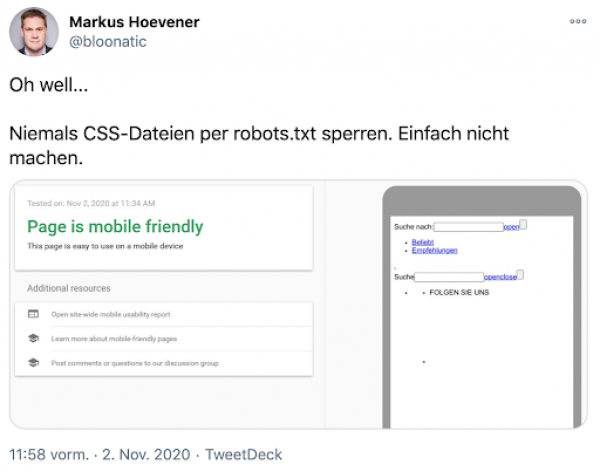

Schade auch, wenn Inhalte, die Google sehen sollte, in der robots.txt gesperrt werden:

Klar, ist zwar immer schön, wenn der Mobile Friendly Check validiert. Aber nicht, wenn das Ergebnis dann so aussieht. Ein Grund, warum wir Fans von möglichst schlanken robots.txt sind, denn der Standard-Eintrag tut es in den allermeisten Fällen und verhindert solche Fails.

Also immer dafür sorgen,

- dass wirklich nur verfügbare und indexierbare Dinge in der XML-Sitemap stehen

- dass die robots.txt nicht zu restriktiv ist und Google vielleicht den Zugriff auf relevante Ressourcen verwehrt

- dass es Dir möglichst direkt und nicht nur durch Zufall auffällt, wenn doch mal was schief geht