„Aber Johan, wieso hast Du denn empfohlen, die Schriftart per Robots.txt zu blockieren? Dann kann Google die Seite doch nicht mehr rendern." 😱

Berechtigte Rückfrage, aber nur auf den ersten Blick. Im konkreten Fall hat das Caching der Schriftarten nicht hingehauen: Google hatte sich ziemlich in die Schriften verliebt und sie immer wieder gecrawlt (so ca. 20k Requests am Tag auf eine Handvoll Dateien). Diese Ressourcen sind besser für andere Dinge zu verwenden. Und selbst wenn dadurch nicht mehr wichtige Ressourcen gecrawlt werden, ist es immerhin gut für die Umwelt.

Um das Crawling zu reduzieren, gibt es verschiedene Möglichkeiten:

-

Caching-Settings fixen und hoffen, dass Google das berücksichtigt

-

Einbindung der Datei für Google unsichtbar machen

-

Status Code und Index-Status verändern (Status 404/410/503, X-Robots: Noindex)

-

Blocken der Datei über Robots.txt

Variante 1 ist best practice: Wir wollen, dass Google alles crawlen und verarbeiten kann. Aber je nach Setup tut sich Technik mit solchen Aufgaben gelegentlich auch schwer.

Variante 2 und 3 mögen wir SEOs eigentlich nicht. Sie verschleiern und SEO bei Obscurity ist meist keine gute Idee. Denn früher oder später fällt es einem immer auf die Füße

Variante 4 nutze ich inzwischen viel lieber als früher. Es ist eine eindeutige Anweisung, es funktioniert und es wirkt mit minimalem Zeitaufwand sofort.

Das Problem beim Blocken per Robots ist aber: Google fehlt die Ressource, um die Seite darzustellen. Ist es also falsch, die Schriftarten zu blocken?

Ich bin überzeugt davon, dass es keinen Impact hat. Denn Google malt die Pixel ja nicht wirklich. Und so lange ich vernünftige Fallback-Fonts definiert habe, passen ja auch alle Objekte weiter an die richtige Stelle.

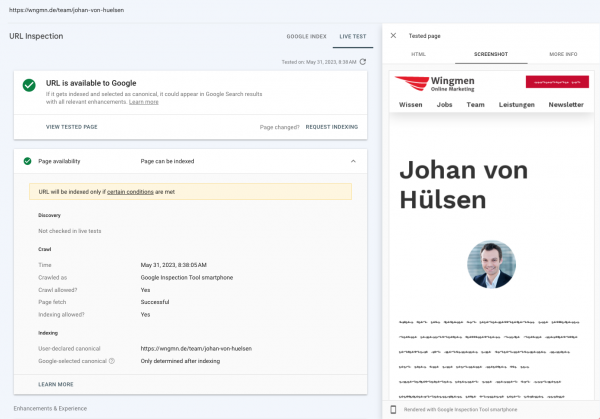

Grau ist alle Theorie. Daher habe ich unsere wichtigste Landingpage zum Test genutzt: Meine Teamseite.

Wingdings war gestern. Heute nutze ich redacted script für den Test:

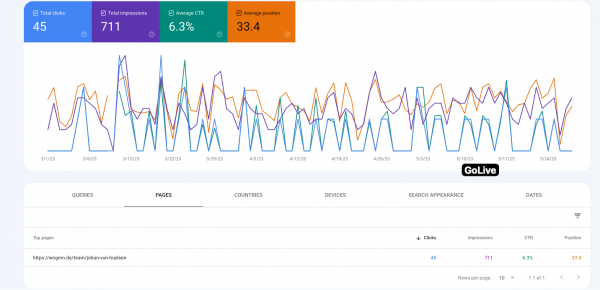

20 Tage nach Go Live und Indexierung sind die unglaublichen Rankings dieser Seite unverändert. Obwohl man die Schrift nicht mehr lesen kann.

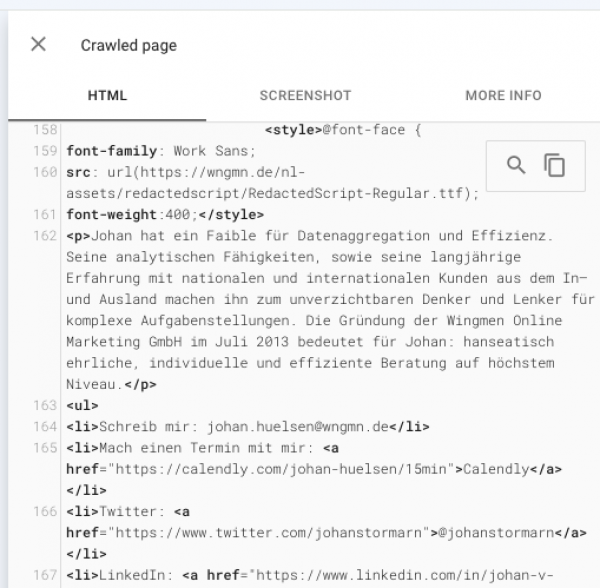

Da die Schriftart aber nur die Darstellung des Textes regelt – nicht aber den Text selbst verändert – hat Google wie erwartet auch weiterhin den Premium-Content dieser Seite unverändert im Index:

Wenn das bei einer so wichtigen Seite funktioniert, dann sicher auch auf Deiner. Und wenn Google die Schriftart egal ist, dann können wir sie auch sperren, wenn sie Crawling-Ressourcen frisst.

Ich habe hier noch nie ein Problem gesehen. Du?